Fra læring om maskiner til maskinlæring

Computerworld har rapportert om datautviklingen i 40 år. På få andre områder har det vært like dramatisk.

Tiåret fra 1983 var preget av datamaskinene. I tiåret fra 1993 skulle internettet skape helt nye virksomheter. De endte som luftslott. Fra 2003 ble det de sosiale tjenestene som en hel verden begynte å benytte. De seneste ti årene er det bare blitt mer av alt, men kunstig intelligens er tidenes snakkis.

I 1983 var datakommunikasjon nærmest et ukjent begrep. En vanlig ansatt i en dataavdeling hadde aldri hørt om TCP/IP. Telefoner var fast koblet til veggen. Televerket styrte utviklingen. Tilsvarende over hele Europa. Man lagde standarder basert på teleutvikling, byråkratiske, tungvinte å implementere.

De første mobile telefonene var tilgjengelige, kostet for mye, veide for mye. Nye standarder måtte til. Ny teknologi måtte til før telefonen kunne puttes i lommen.

Programmeringsspråk

Ellers var fagfolkene opptatt av programmeringsspråk. Femte generasjon språk skulle gjøre alt mer logisk, men førte ikke til noe. Tredje generasjons språk som eksempelvis Fortran, benyttes den dag i dag. Fortrans formål er beregninger som benyttes på verdens kraftigste maskiner. Norges største, Betzy, er på 129. plass over verdens kraftigste maskiner i juni 2023.

Formål har preget utviklingen av programmeringsspråkene. Norsk forskning skapte Simula, et objektorientert språk. Disse ideene ble overført til Java ett av verdens mest brukte utviklingsspråk. Siden har mange flere språk kommet til. Mest populært i dag er Javascript og Python.

EDB

I 1983 var det ikke snakk om IT, informasjonsteknologi, men EDB, elektronisk databehandling. Allerede i det uttrykket hadde fagfolkene klart å formidle det vesentligste. Derfor gjøres jobben av en datamaskin.

«En fantastisk betegnelse» sa amerikaneren som overhørte to nordmenn diskuterte datamaskiner på en datakonferanse i USA.

For det handler om bearbeiding av data fremfor tekniske beregninger som grunnlag for bruk av datamaskiner. Men uten tekniske beregninger hadde Norge kanskje vært et fattigere land, for olje og gassutvinning krever enorme utregninger. Tilsvarende gjør vitenskap. Astrofysikk og DNA-sekvensering er to eksempler.

Værmeldingen er det mest praktiske eksemplet på omfattende beregninger, det vil si computing. På engelsk betegnes datamaskinen for Computer som i PC, personal computer.

Men det foregår veldig lite beregninger i de fleste pc-er, men veldig mye databehandling.

Ifølge en analyse som Digitaliseringsdirektoratet har fått utarbeidet, vil deling av data spare samfunnet for milliarder hvert år.

Epoke

Datamaskinepoken var på høyden i 1985, fikk sitt nådestøt med børskrakket Black Monday 19. oktober 1987, og ble borte på nittitallet.

Utfordringen var at alle datamaskinene var forskjellige. Alt i maskinen var utviklet av datamaskinprodusenten. Det ble for høye priser, for få maskiner å fordele kostnadene på. Med egen prosessorteknologi, operativsystem og systemprogramvare ble det for kostbart.

Selv verdens største dataleverandør, IBM, holdt på å gå overende på nittitallet, for dårlig salg, for mange ansatte. Da var en hel gruppe datamaskinprodusenter radert vekk.

Gruppen ble betegnet minimaskinleverandører for de startet med små maskiner som siden vokste. Digital var stjernen. Norsk Data, Norges stolte utfordrer, ble sett på som et industrieventyr.

Digital holdt ut lengst, hadde mest teknologi som ble solgt i biter før Compaq svelget restene.

Før den tid, hadde minimaskinleverandøren prøvd å gjøre seg mer attraktive. 17. mai 1989 fortalte toppsjefene i de mange leverandørene at de var enige om et felles datamaskinmiljø, Unix. Deretter begynte diskusjonen om den rette versjon frem til 1993, men da var det for sent.

Pc-en kommer

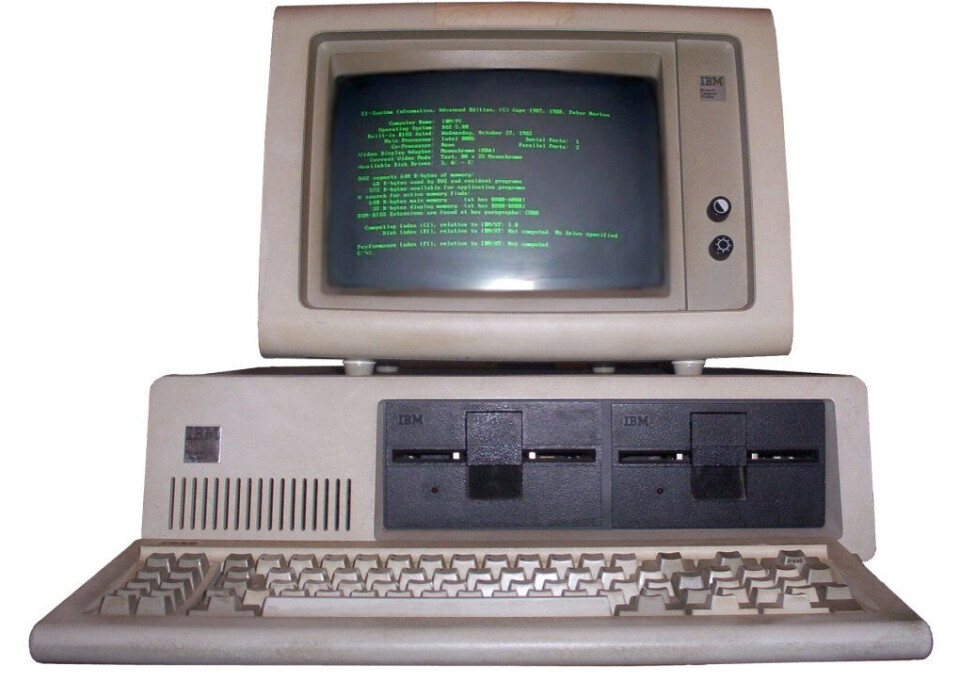

I 1983 kom

pc-en til Norge. IBMs spesifikasjon på en personlig datamaskin påvirket mange

produsenter. Compaq ble den nye stjernen. Intel og Microsoft bestemte farten på

utviklingen.

Men det var knotete å lære seg å bruke en pc. Det var utfordrende å sette seg inn i bruken av datamaskinene virksomhetene skaffet for faglige oppgaver. De store bedriftene kodet egne applikasjoner, de mindre skaffet seg løsninger. En egen konsulentbransje vokste frem for å bidra til best mulig resultat.

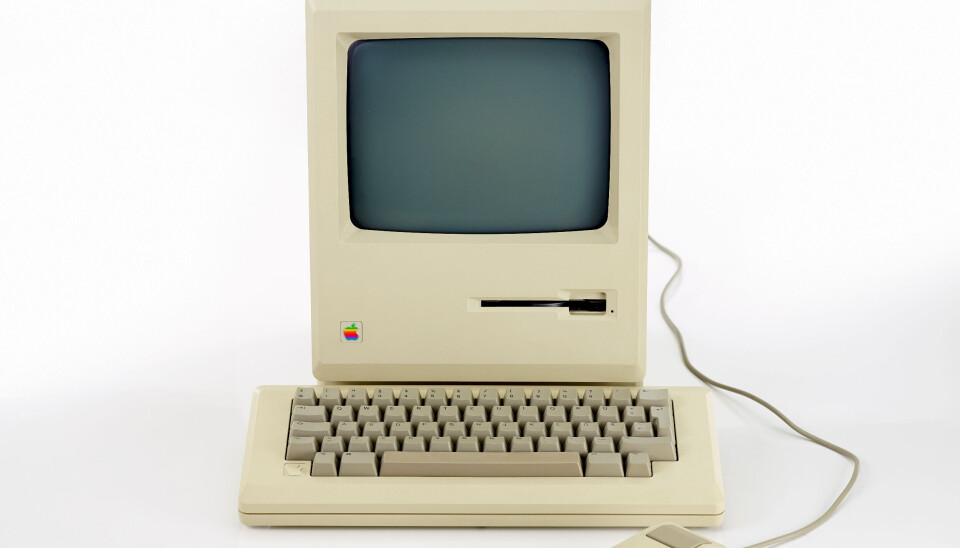

Men alt snudde på slutten av åttitallet etter at Apple hadde introdusert Macintosh. Grafisk betjening var en teknisk revolusjon. Mus ble et hjelpemiddel, oppfunnet av norskættede Douglas Engelbart på Xerox Parc, forskningssenteret til Xerox.

For det var på Xerox at Apples grunnlegger Steve Jobs forsto verdien av grafisk betjening. Microsoft forsto også, men det var først med Windows 3.11 i 1993 at Microsoft begynte å bli brukervennlig.

World Wide Web

Grafisk

er først og fremst stikkordet for internett. For den tredje mai 1993 ble World

Wide Web donert av den europeiske organisasjonen for kjernefysisk forskning,

CERN, til fri benyttelse.

Frem til da var det bare spesialister med interesse for datakommunikasjon som kjente til internett og TCP/IP. I Norge var internett kjent i forskermiljøer, for den første programvaren for det grafiske miljøet ble utviklet på en maskin fra Norsk Data. Det endelige resultatet ble til på en maskin fra Steve Jobs NeXT, verdens første web-server.

Timothy Berners-Lee kan ikke hylles nok for sin innsats for internettet. Også Håkon Wium Lie må hylles for sin innsats med stilark, Cascading Style Sheets som gjør at det grafiske miljøet tilpasser seg brukerens hjelpemiddel.

Nettlesere ble det heteste for å komme til en maskin på nettet. Selv Microsoft forsto at nettleser måtte være en del av brukermiljøet, men det skjedde først i 1995.

I de etterfølgende årene oppsto det en farsott. Alle skulle på nettet for å tilby sine produkter, å bli rike. Geografi var ikke lenger så viktig. Kunder via web var viktig. For web utviklet seg til å bli et nettverk av nettverk.

.com ble til .hot. Det måtte gå galt. .hot ble til .not. Det eneste selskapet som overlevde var en bokhandel på nettet, Amazon. Selskapet har i løpet av de neste 20 årene revolusjonert handel på nettet og er en suksess uten like.

Prosessorene

Egenutviklete prosessorer ble nærmest borte på nittitallet. Intel og AMDs pc-prosessorer ble kraftigere og kunne påta seg dedikerte oppgaver. Nesten bare IBM videreutviklet sine prosessorer. Ett alternativ fantes, ARM, en prosessorspesifikasjon definert på Cambridge i England.

PC-nett ble populært i en rekke kretser, først for lagring av data og utskrift. For fagfolkene hadde begynt å skille mellom brukerbehov og fellesbehov, betegnet som klient/tjener.

PC-server ble et begrep fordi kraften økte og driftsmiljøet ble stadig bedre i maskinene som Compaq og Dell laget. I løpet av nittitallet ble det mange tjenestemaskiner, mange av dem innkjøpt på avdelingsbudsjetter.

Maskinene for luftslottene var for det meste kraftige med egenutviklete prosessorer og Unix som driftsmiljø. Sun hadde sin storhetstid på nittitallet med Sparc og Solaris, IBM tilsvarende med IBM Power og AIX.

Da luftslottene forsvant i 2000, ble det mange kraftige Sun-maskiner på billigsalg. Sun ble langsomt borte. Restene ble kjøpt opp av Oracle som fikk kontroll med Java.

Siden er det bare få fagfolk som har et forhold til Unix. Mange har derimot et forhold til Linux som ble utviklet på nittitallet på grunn av problematisk lisensproblematikk for Unix.

Håpet var at Linux skulle bli en favoritt på pc-ene, men det skjedde ikke, men for å håndtere web og beregninger har Linux blitt en suksess.

Årtusenskiftet

På slutten av nittitallet kom begrepet Y2K på alles lepper. Dommedag ble det spådd om ikke alle applikasjonene, administrative og tekniske ble kodet om fra seks sifre i dato til åtte.

Problemstillingen hadde først blitt omtalt i Computerworld i 1993. Kostnadene ble anslått til 300 – 800 milliarder dollar. USA vet de brukte over 100 milliarder dollar.

Revisjonen var sikkert nyttig, men for det meste unødvendig. Kun ved beregning på datoer er åtte siffer nødvendig. Overgangen til 2000 gikk nærmest smertefritt.

En kunde som leverte tilbake sin leide video i New York fikk en regning på 91.250 dollar for hundre års for sen levering. Første barn født i Danmark ble nummer 100.

Sosiale nettverk

Årtusenskiftet satte større fokus på forbrukerne. Sosiale nettverk ble en farsott. Først ble Google synonymt med søk, godkjent som verb for søk på engelsk. Deretter kom en rekke oppkjøp hvorav Youtube kanskje er mest kjent.

Sosiale forbindelser gjorde Facebook til en kjempesuksess. Fra 2006 har Facebook erobret verden til tross for mange kontroverser.

Forutsetningen er web hvor .com igjen ble .hot.

Siden har det ene nettstedet etter det andre søkt å erobre brukeres interesse. Bruk er gratis. Annonsering og statistiske analyser skaffer inntekter.

Stadig flere tjenester blir tilgjengelige. Amazon har utviklet seg til et konglomerat av tjenester hvor e-handel og datatjenester dominerer.

Smarttelefon

Selv om ikke prosessorer hadde samme interesse som tidligere, var det nettopp prosessorene som bidro til at internettet ble en suksess, at mobiltelefoner utviklet seg til å være noe mer enn en telefon.

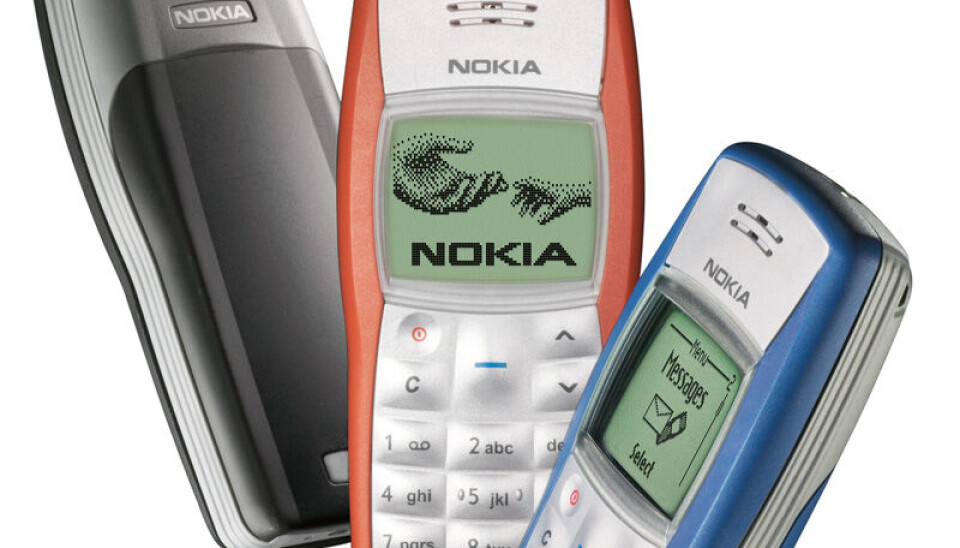

Finske Nokia dominerte, men forsto ikke nødvendigheten av enkel grafisk betjening. Steve Jobs forsto etter at han kom tilbake til Apple. Grafisk betjening og små applikasjoner (apper) pakket inn i en elegant mobiltelefon kom i 2007.

Siden har mobiltelefonen blitt en lommedatamaskin hvor telefonfunksjonen er nødvendig, men hvor sosiale apper som Facebook, Snapchat, Whatsapp og Youtube dominerer i tillegg til praktiske funksjoner som bank, kalender, nyheter, post, og hvor vær er selvsagt. I tillegg kommer alt av praktiske hjelpefunksjoner. De fleste brukere har flere sider med apper på telefonen.

Utfordringen er når jobb og privat er på samme telefon. Sikkerhet har vært en utfordring de seneste 20 årene. Det synes ikke som det blir bedre.

Kapasitet, kapasitet

Bedrifter og privatpersoner måtte forbedre nettverkskommunikasjonen for å få tilfredsstillende tilgang til internett. Fiber til hjemmet ble slagord. Opprinnelig hevdet forståsegpåere at 8 M bit per sekund dekket alle behov. Nå er det snakk om så høy hastighet som mulig.

Utfordringen er å skaffe alle, tilstrekkelig kapasitet. Selv det offentlige forutsetter internettforbindelse. Det er vanskelig i spredd bebyggelse, for det koster å legge fiber. Myndighetene har bidratt gjennom mange år, men det tar tid.

Alternativet er trådløst. Fast trådløst internett kommer til å få større betydning; stikkord 5G.

Smarte dingser

Apple har forstått at deres programvare krever det ypperste av prosessorer for å fortsatt friste nye brukere. Japansk utviklingsmodell med stadig forbedringer gjør at mange brukere stadig skaffer seg ny modell.

Utstyr lages bare for brukere, ikke lenger for fellesformål. Ipod var en tidlig favoritt. Nå er musikk bare en funksjon. Nettbrettet Ipad kom i 2010 og er fortsatt best. Med tilkobling av tastatur er Ipad nærmest en pc. Etter Ipad kom Apple watch 2015, en smartklokke som konkurrenter ser på som et forbilde.

Alle de forskjellige enhetene krever bearbeidingskapasitet. Derfor har Apple gjort en rekke utskiftninger av prosessorer de seneste årene. Nå er det egenutviklet prosessor basert på ARM.

Men Android hvor Samsung er største leverandør er det mest omfattende mobiltelefonmiljøet, basert på Linux. Bortsett fra de kinesiske produsentene er det Android som benyttes fra en rekke forskjellige konkurrenter som Motorola.

Prosessorer

Under internet-boblen var det kraftige maskiner med egenutviklete prosessorer fra Hewlett-Packard, IBM og spesielt Sun som kjørte ordresystemene. Etter det sprakk var det lite interesse. Sun-maskiner kom på billigsalg.

Samtidig hadde AMD og Intel utviklet prosessorer som etter hvert kunne administrere mer enn 4 GB minne, helt nødvendig for mange samtidige brukere eller store arbeidsoppgaver, applikasjoner. Den første prosessoren kom i 2003. 20 år senere er det nærmest bare IBMs prosessorer som er et alternativ.

Verdens største datamaskiner benytter AMD, Intel eller IBMs prosessorer. De største datasentralene bruker veldig mye Intel. Mange håper på prosessorer basert ARM, men det vil ta tid. Det må være et stort programvaremiljø før det kan vokse ut over dedikerte oppgaver som nettverksmaskiner.

Virtualisering

Server ble et begrep på nittitallet, pc-server, en maskin for å håndtere brukeres felles oppgaver som eksempelvis mail. Sammenlignet med datidens større maskiner kostet serveren en brøkdel.

Etter hvert ble det mange servere, altfor mange. De formerte seg nærmest som kaniner. Ulempen var arbeidet og kostnadene ved administrasjonen.

Etter hvert kom det frem at maskinene ble dårlig utnyttet, typisk fem prosent av kapasiteten, en oppgave, en maskin. Det ble derfor et mål å oppnå bedre utnyttelse. Virtualisering ble svaret.

Virtualisering hadde vært brukt siden 60-tallet. Opprinnelig var ideen å late som maskinen hadde mye større hukommelse enn den hadde. Oppgavenes krav til hukommelse var større enn den fysiske. Derfor ble oppgavene splittet opp slik at kun den delen som det ble jobbet med, var aktiv.

Skyen

Og late som har blitt strategien for nåtidens virtualisering. En fysisk server lot som den var 20. Oppgavene fra disse 20 ble overført til en fysisk som dermed håndterte 20 virtuelle maskiner.

Det ble færre maskiner, men antall oppgaver økte. Det ble derfor en diskusjon om egen driftsadministrasjon av maskinene eller la andre gjøre jobben. Utsetting ble svaret for mange. En internasjonal partner garanterte at kostnadene for administrasjonen av alle maskinene ville gå ned, typisk 30 prosent, men kostnadene ved den menneskelige kommunikasjonen ble først oppdaget senere. Da tok store selskaper datamaskinene og oppgavene tilbake.

Istedenfor tilbød store datasentraler å overta oppgavene dine. Cloud, skyen, ble et begrep. Ideen med utsetting var ikke glemt. Små firmaer hadde alltid gjort det via regnskapsfirmaer. Lønn har alltid vært satt ut.

Amazon forsto det først og bygget seg opp, ikke bare med tilbud på kundeoppgaver, applikasjoner, men også på tekniske ressurser som lagring av kundens data.

Noe her og noe der, har blitt helt vanlig, personlig sky og offentlig sky. Større firmaer har fått flere skyleverandører, avhengig av type oppgave.

Alle de store amerikanske it-firmaene vil være skyleverandører, typisk Amazon, Alibaba, Google, IBM, Microsoft, Oracle, Salesforce og SAP. Dell og Hewlett Packard Enterprise vil også være med. I tillegg finnes mange lokale leverandører som eksempelvis Tieto Evry og Orange.

Virtual reality

Virtuell har også andre tolkninger. Ved hjelp av spesialprogramvare og tilpassete briller kunne brukere oppleve en virtuell verden hvor man kunne utføre oppgaver som ikke kunne gjøres i den virkelige verden.

Virtual Reality, VR, ble et begrep og har vært det de seneste 40 årene. Men først i de senere årene er VR blitt mer praktisk enn eksotisk. Opplæring for å håndtere farlige situasjoner er ypperlig for VR. Det er teknologiutviklingen som gjør det mulig.

Blandingen av virkelig og virtuell er veldig spennende. Augmented Reality, AR, eller utvidet virkelighet, gir fagfolk nye muligheter, eksempelvis innen medisin. Microsofts briller er ypperlige for AR.

Fra boble til realitet

Et moderne tjenestetilbud ville ikke vært mulig uten internett. Det internett-boblen drømte om er realisert. Grunnen er web-tjenester og fiber.

Alle mulige virksomheter har web-sider med informasjon. Ingen tenker lenger over det, bare at sidene ikke er gode nok. Visuell design er derfor et fagfelt som får større betydning. Det skal være intuitivt samtidig som viktig informasjon kommer raskt frem, og dataregistreringen gjøres enklest mulig.

For alle virksomheter tar det for gitt at brukere ikke trenger opplæring. Web-sider må derfor revideres kontinuerlig. Typisk er nettbank.

Også fagapplikasjoner trenger forbedringer av den visuelle designen, fagfolk skal ikke bruke for mye tid på inntasting av data. Sekretær er et yrke som nærmest er radert ut i løpet av de seneste 40 årene.

Nå er det snakk om gigabit per sekund, for dataene skal overføres fra der de er lagret til brukeren i forbindelse med enkle oppgaver som ordreopptak, eller avanserte som dataanalyse.

Lagring på mindre plass

Databaser og lagringsmedier har vært helt nødvendige for å ta vare på alle typer data. 20 – 200 MB var typiske størrelser i 1983. Plater med diameter på 14 tommer lagret 2 GB.

Etter hvert endret de fysiske størrelsene seg. Diameterne ble redusert, og nå er 2,5 og 3,5 tommer standard hvor den største rommer 20 TB. Dette er basert på magnetisk lagring.

Utviklingen de førti årene har økt lagringskapasiteten en million ganger samtidig som størrelse er redusert fra 8 tommer til 3,5.

Elektronisk lagring i form av flash som alt av minnepinner, pc-er og lagringssystemer benytter, kan nå lagre inntil 100 TB, typisk 2 TB i en pc.

Databasen

Relasjonsdatabasen var et fremskritt, definert av IBM, dominert av Oracle. Basen definerer sammenhenger mellom data, men de optimaliserte søkene blir komplekse og tar mye plass.

En av hensiktene var å lagre data bare en gang. Det sparer plass, men tar lenger tid for å finne dataene.

Det finnes mange alternativer. Men alle må benytte avansert matematikk for å lagre og gjenfinne. For datamengdene har blitt så store at databaser distribueres. Og alt er ikke bare tekst og tall. Dokumenter og video gir andre utfordringer.

Konferanser

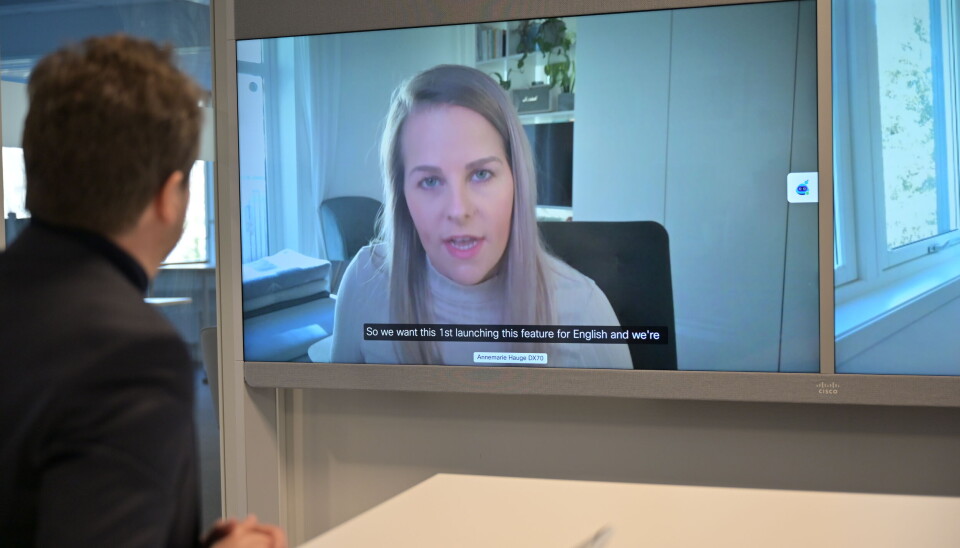

Videokonferanser ble et viktig tilbud til ledelse og prosjektgrupper som ikke alltid kunne møtes fysisk. Egne rom ble bygget for å kunne se og snakke med andre møtedeltagere.

Ulempen var at det var kostbart med store skjermer og kvalitetslyd. Mange videorom ble stående ubrukt mesteparten av tiden.

For kostnader har holdt tilbake utviklingen av videokonferanser. Spesialutstyr til mange ganger prisen av en pc for å være deltager i et møte, krever hyppig bruk for å forsvare anskaffelsen.

Tandberg og Polycom var to dominerende tilbydere, men Tandberg ble kjøpt opp av Cisco og Polycom av HP.

Først under nedstengningen av samfunnet ble det større interesse for visuell kontakt. Men da var det andre virkemidler, Skype og Zoom. Skype var svensk, men ble kjøpt av Microsoft, men mistet mange brukere til Zoom under nedstengningen.

Zoom er gratis, men utvidet bruk må det betales for. Hundre personer kan delta i en konferanse i 40 minutter, uten at det koster, men sikkerheten har vært dårlig og personlige data overføres til USA. Personvernet tilfredsstiller ikke europeiske regler.

Men i dag er det ingen som tenker over det når personer deltar i nyhetsinnslag via videokonferanse.

Brukere av Apples telefoner bruker Facetime, særlig over store avstander som mellom Norge og Brasil.

Kunstig intelligens

De seneste fem årene er det en utvikling som dominerer, kunstig intelligens, KI eller AI. KI er ikke nytt, men har fått fornyet interesse, først og fremst på grunn av prosessorutviklingen som har medført at avansert programvare kan bearbeides på en fornuftig måte.

I enklere form har KI blitt brukt de seneste førti årene. Ansiktsgjenkjenning er et typisk eksempel.

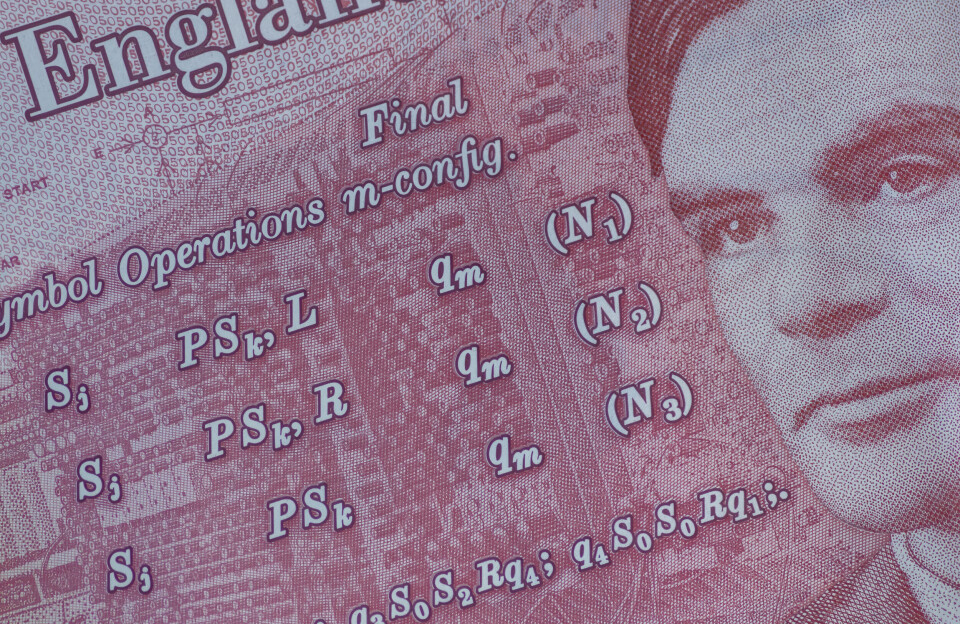

Opprinnelsen strekker seg tilbake til 1940-årene og Alan Turing, fortsatte med Marvin Minsky på femtitallet. Den gangen ble det uttalt at om 20 år ville det være aktiv bruk av kunstig intelligens. Slik ble det ikke.

Det ble stopp i forskningen fordi resultatene uteble. Og slik har det vært mange ganger siden sekstitallet.

Fornyet interesse kom da ekspertsystemer ble populært på 80-tallet og videreført av eksempelvis Oracle og SAP i sine forretningssystemer etter årtusenskiftet.

ChatGPT

Siden har maskinlæring blitt populært. En datamaskin fores med enorme mengder data om en problemstilling som så lærer å gjenkjenne tilsvarende data for fremtidige beslutninger. Det har vært mye feil, men det blir langsomt bedre.

Nå er det kunstig intelligens fra OpenAI i form av ChatGPT, en avansert språkmodell. Programvaren kan skrive veldig gode tekster om datagrunnlaget er korrekt. Dette blir forferdelig vanskelig for norsklærere.

GPT-teknologien vil påvirke alt som Microsoft gjør som har investert tungt i OpenAI. Men ikke bare Microsoft, også de fire andre store Amazon, Apple, Facebook og Google vil påvirke utviklingen av kunstig intelligens.

For veldig mye vil handle om parallell behandling av massive mengder data. Til det benyttes GPU-er (Graphical Processing Unit) som gir en behandlingskapasitet som tidligere nærmest var utenkelig.

Alarm

Kunstig intelligens vil bli det nye virkemidlet til svindlere. Data om ofrene kombinert med en god språkmotor kan virke veldig overbevisende i en investeringssituasjon.

Økokrim er veldig bekymret og slår alarm etter mange svindler i 2022. Sikkerheten må forbedres hos virksomheter og privatpersoner.

Også tungvektere i it-industrien slår alarm. Vi må ikke benytte løsninger basert på kunstig intelligens ukritisk. En etisk diskusjon om bruken er ikke til å unngå.

Skuffelser av oppnådde resultater er ikke til å unngå. Alle jobbene som skal bli borte, kan unngås, men innholdet kan bli betydelig endret.